SIGNALS+ 在线快讯订阅

持续关注Signals+,了解有关连接、数字健康、电气化和智能工业的最新见解、信息和想法并加以利用。

借助边缘侧AI与数字预失真提升5G能效

虽然5G已深刻改变世界,并兑现了高速率、低延迟、高密度连接的承诺,但也伴随着一项隐性代价:不容忽视的能耗成本。据爱立信预测,到本十年末,5G用户数量将达到67亿。1 然而,尽管5G的数据传输效率远超4G网络,但由于承载的数据量更大,5G的能耗将比传统网络高出4至5倍。2

这一挑战的核心在于无线接入网(RAN)的功耗。RAN网络消耗了绝大部分电力,尤其是在功率放大器(PA)环节。为了在能效比与信号失真、更宽工作带宽及更快速信号变化之间寻求平衡,RAN开发者如今对灵活性、智能化和实时优化提出了更高要求。简而言之,RAN设备需要具备更强的适应性。

面对5G系统在适应性与能效方面的新压力,技术人员已将目光投向快速发展的人工智能(AI),探索AI有望带来的新能力。除了备受关注的大语言模型,AI在真实的本地决策领域也正涌现新机遇,能够借助AI的分析优势,实时应对各类复杂应用场景。无线通信领域的技术人员已着手研究如何运用AI的能力来优化RAN功耗,并从中看到了机遇。

对于移动运营商而言,推动AI融合的举措可谓恰逢其时。事实上,麦肯锡的研究发现,能耗对运营商净利润的影响比销售额增长高出50%。3 与此同时,Verizon、T-Mobile、Bharti Airtel等众多通信运营商均已承诺在2050年前实现净零排放目标。

在5G时代,网络能效问题愈发严峻。尽管4G网络的能耗成本已占网络总拥有成本的20%至25%,4 但向5G的过渡大大加剧了这一压力。在某些场景下,高性能5G部署(尤其是叠加在传统2G、3G和4G基础设施之上时)可能导致能源需求增幅高达140%。2

技术讨论

引发5G时代功耗上升的三大因素:5

大规模MIMO

相较于当前的2×2或4×4 MIMO配置,5G大规模MIMO (M-MIMO)基站“信号塔”规模更大、性能更强,最大支持64×64配置(规模较传统方案高16倍),能耗也显著增加。例如,一座5G基站的耗电量是4G基站的3倍。

基站数量增多

进入5G时代,城市区域需通过新增宏基站与小型基站实现网络密集化,这将进一步推高总能耗。

移动数据流量增长

结合“比特驱动瓦特”的理念,不难发现:即便5G在单位比特能效比上表现更出色,但受移动数据流量高达50%的增长幅度影响,整体网络的功耗仍会随之攀升。

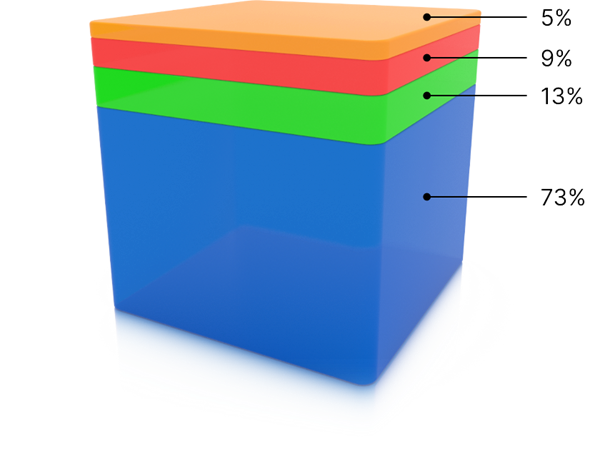

运营商能源使用情况

资料来源:全球移动通信系统协会(GSMA);2021年能源消耗分布6

其他运营

其他运营

数据中心

数据中心

核心网络

核心网络

无线网络

无线网络

5G的能源挑战

5G能耗问题的核心在于一种微妙的权衡:功率放大器(PA)在接近满负荷运行时能效最高,但这种运行模式会导致信号失真,进而引发合规问题并降低性能。为规避此类风险,大多数PA会采用回退模式,以牺牲能效为代价来维持信号保真度。

“记忆效应”进一步加剧了PA的非线性问题。PA包含一些响应速度较慢的元件,它们会“记住”先前的输入信号,导致PA的非线性程度取决于流经自身的过往信号。

数字预失真(DPD)技术可解决此类问题。

DPD的工作原理

DPD的工作机制是:预先对信号进行失真处理,且失真方向与PA通常产生的失真方向相反。这类似于裁缝缝制衣物时会预留额外尺寸,因为知道衣物洗涤后会缩水;DPD则会预先调整信号,使得信号流经PA时,两种失真能够相互抵消,从而保证传输的信号清晰且准确。

未来的演进方向十分明确:借助AI实现更智能的DPD。

技术讨论

当前的DPD解决方案依赖于一种基于数学模型的方法,即基于沃尔泰拉的线性化,用于对PA的特性进行建模。在5G传输场景中,这类模型的复杂度会呈指数级增长,进而需要更多的计算资源和存储资源,导致芯片面积和能耗大幅增加,最终削弱DPD带来的能效收益和应用价值。

新范式:基于机器学习的数字预失真

如今,新兴技术开始借助机器学习(ML)取代传统DPD中固定的数学模型。工程师无需手动调整信号校正算法,而是可以利用经真实波形数据训练的神经网络,对PA的非线性特性进行动态建模与实时校正。这些模型可通过反向传播算法优化,并直接映射到现有硬件结构中。

基于机器学习的数字预失真(ML-DPD)应运而生。

ML-DPD的优势具有深刻影响:优化时间可从数天缩短至数小时;在各类信号条件下,模型性能均有所提升;节能不再停留在理论层面,而是具备了实际意义。最重要的是,这类解决方案具备自适应能力,能够从实时工况中学习,并随硬件与环境的变化而动态调整。

中期数字预失真(MT-DPD)

尽管当前的DPD技术已具备一定效果,但不断发展的蜂窝通信需求正不断挑战DPD的性能边界。为实现更大数据量、更快速度的传输,功率放大器(PA)必须在更宽的带宽范围内工作,而这会导致信号快速变化。这种快速变化可能引发电气不稳定和信号失真,存在超出美国联邦通信委员会(FCC)发射限值的风险。

为解决这一问题,研究人员开发了一种基于神经网络的新模型,能更好地理解并应对信号的动态变化。

技术讨论

通过将这种模型与在系统采样率下运行的基于沃尔泰拉的DPD模型相结合,中期数字预失真(MT-DPD)技术得以诞生。这种技术专门针对持续时间在100纳秒至10微秒之间的信号记忆效应所导致的失真。早期测试表明,这种技术能显著降低失真程度。7展望未来,研究重点可能会转向解决电荷俘获问题,这是氮化镓(GaN)器件面临的另一大性能障碍。

长期解决方案

如今,PA面临的挑战不仅限于静态失真。5G中的动态流量加剧了长期记忆效应,尤其是基于GaN的高效率PA中因电荷俘获导致的问题。AI驱动的方法同样能够对这些特性进行建模,将DPD的能力扩展到新领域。

技术讨论

分层神经网络如今能够同时校正和适应由即时非线性、快速变化的瞬态和缓慢漂移效应导致的失真。由此打造出一套统一的系统,能够在实际场景中提供高信号保真度,同时保持高水平的PA效率。7

ML-DPD:移动运营商的高能效未来

ML-DPD解决了行业的一项实际需求:提升基站能效。这对移动运营商而言至关重要,他们在5G基础设施上投入巨大,必须通过降低成本来提升竞争力。在保持合规的同时以最优容量传输信号,是一项重要优势,让我们得以享受高速的移动互联网体验。

信号优化已不再仅仅是工程层面的考量,更成为业务层面的一项必然要求。ML-DPD为控制5G能耗提供了一条可行路径。

参考文献

1 “Mobility Report”,爱立信,2024年11月。

2“What Is 5G Energy Consumption?”,VIAVI。

3 “The Growing Imperative of Energy Optimization for Telco Networks”,麦肯锡,2024年。

4 “5G Energy Consumption: A Rapidly Changing Business Climate”,STL Partners,2021年。

5 “5G Era Mobile Network Cost Evolution”,GSMA,2019年。

6“Energy Consumption Breakdown”,GSMA,2021年。

7ADI独立测试。